| El Po1 tiene su propia dirección mac |

Etherchannel también es conocido como Port Channel, Channeling, Link Aggregation o Nic Teaming.

En realidad lo que hace es ocultar las interfaces físicas a los protocolos de capa superior como STP. En un enlace de 2 interfaces de 100 MB, STP lo verá como un solo enlace de 200 MB. Además, esto hace que el STP esté en un estado de Forwarding-Forwarding y no Forwarding-Standby: el PO1 siempre está en Forwarding.

Es importante configurar bien cada lado, con el protocolo y el modo correcto, ya que podría crearse un bucle.

Recordemos que cuando agregamos dos o más enlaces no aumentamos el ancho de banda, sino que creamos otro camino más. Los flujos no pueden superar el ancho de banda de las interfaces individuales.

Cuando agregamos enlaces (LAG) podemos "polarizar" el tráfico en un solo nodo.

Imaginemos un servidor y varios pc's queriéndose comunicar por http a través de 2 switches que tiene un Etherchannel montado. La primera vez que que el switch tenga que decidir por donde mandarlo lo hará aplicando el input hash del algoritmo, por ejemplo, basado en la mac de origen. Pero una vez elegido uno de los 2 enlaces del Po1, la siguiente comunicación será en base a la dirección mac de origen, el tráfico http de ese pc y de otros pc's tomará el mismo enlace del Po1, polarizando uno de los nodos.

Esto se puede configurar a nivel de config:

(config)#port-channel load-balance (dst-ip; dst-mac; src-ip; src-mac)

En algunos casos nos repartirá bien el tráfico, pero en otros no, como por ejemplo varios "flows" con el mismo protocolo desde un mismo cliente.

En la generación Nexus se amplía el rango de configuración. Podemos hacer que separe por vlan y también a nivel de capa , usando los puertos tcp y udp asignados para distinguir sesiones de un mismo cliente o servidor y balancear por los diferentes enlaces.

LA NEGOCIACIÓN

Ahora vamos a configurar ambos switches para que negocien:

int range e3/2 - 3

(config-if-range)#channel-group 1 mode active

| show etherchannel summary |

Ahora vamos a hacer un cambio individual en uno de las dos interfaces que forman el Po1 del MLswitchB:

MLswitchB(config-if)#switchport trunk allowed vlan remove 40

| Si cambiamos la velocidad de la interface también sucederá |

Observad que el log ya nos avisa de un error y si volvemos a mirar el etherchannel, vemos que la interfaces e3/2 está suspendida, por lo que ya no tenemos el Po1 correctamente formado.

Hay una característica para Ethernchannel llamada "Misconfiguration Guard". Esto hace que detecte errores de configuración para Etherchannel como parámetros específicos, velocidad, duplex y si un puerto está en trunk y el otro en access.

Para configurarlo:

(config)#spanning-tree etherchannel guard misconfig

Con un "show spanning-tree summary" podemos ver habilitada esta característica

MLAG (Multichassis LAG)

No por tener redundancia de enlaces tenemos el problema resuelto. Si tenemos un servidor conectado por 2 enlaces a un switch y el switch, el equipo, el hardware, falla, la redundancia no nos sirve para nada.

También podemos tener 2 switches y un enlace del servidor a cada switch. Aquí sería el servidor el encargado de distribuir separando los diferentes "flows", pero se nos puede presentar un problema de "MAC Flap", especialmente si tenemos máquinas virtuales en el mismo servidor y queremos enviar tráfico a varios destinos desde la misma máquina virtual.

También se puede dar que el software de balanceo de carga no sea capaz de mantener los dos enlaces en active-active. Solo mantiene uno activo (active-standby) perdiendo el 50% del ancho de banda.

Y aquí es donde entre MLAG como solución. Lo que hacemos es engañar al servidor y hacerle creer que tiene dos enlaces al mismo switch. Para ello hay que formar un "logical chassis" entre dos switches virtuales y conseguimos usar el 100% del ancho de banda.

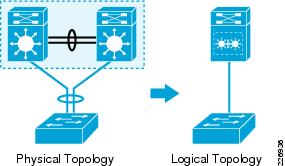

|

| Convertimos un triágulo físico en un P2P lógico |

A través del Control Plane, los dos switches físicos se ponen de acuerdo para enviar la misma dirección mac de origen tanto por un enlace como por el otro. Así conseguimos evitar el mac flapping y dejamos los dos enlaces en un estado de "active-active". El switch envía tráfico por los dos enlaces a la vez y el servidor cree que solo hay un switch.

Las tecnologías usadas para este objetivo dependen de la plataforma que tengamos como Stackwise en Catalyst pequeños para la capa de acceso o Virtual Switch System como en los 6800 para un Core.

Cisco le llama MCEC (Multichassis Etherchannel) a la tecnología para sincronizar los "Control Plane". Cada fabricante desarrolla el suyo y no son compatibles. MLAG son las siglas estándar.

Stackwise Cross Stack Etherchannel

- Para switches de acceso tipo 2960, 3650, 3750, 3850

- La sincronización del Control Plane es a través de cables stack

- Estos cables crean un bucle cerrado bidireccional

- Un Control Plane es compartido por todos los miembros del stack

- Un Management Plane es compartido por todos los miembros del stack

- Hay un Master y los demás miembros son esclavos

- El límite de equipos depende del modelo. Por ejemplo, 9 para los 3750-X

- Documento sobre Stacking de Cisco

Virtual Switching System (VSS)

- Para plataformas tipo 4500, 6500, 6800

- La sincronización del Control Plane es a través de VSL (Virtual Switch Link). Lo típico son 2 x 10 GigE LAG

- Un Control Plane es compartido por todos los miembros del VSS

- Un Management Plane es compartido por todos los miembros del VSS

- Normalmente hay 1 miembro activo supervisor y 3 en standby.

- Siempre tienen que instalarse por pares

- Documento sobre VSS de Cisco

Virtual Port-Channel (vPC)

- Para plataformas de data center tipo Nexus 5000, 7000, 9000

- La sincronización del Control Plane es a través de vPC Peer Link. Lo típico son 2 x 10 GigE LAG

- 2 Control Plane independientes en el vPC

- 2 Management Plane independientes en el vPC

- Normalmente hay 2 miembros activo supervisores y 2 en standby.

- Parecido a VSS pero al tener dos planos hay que hacer 2 configuraciones individuales.

- Siempre tienen que instalarse por pares

- Documento sobre vPC de Cisco

Es importante configurar estos enlaces con un protocolo de agregación tipo LACP. Si los enlaces para formarse se caen y los equipos no pueden comunicarse, el LACP creará un identificador único para cada equipo y la topología será la formada por Spanning Tree.

No hay comentarios:

Publicar un comentario